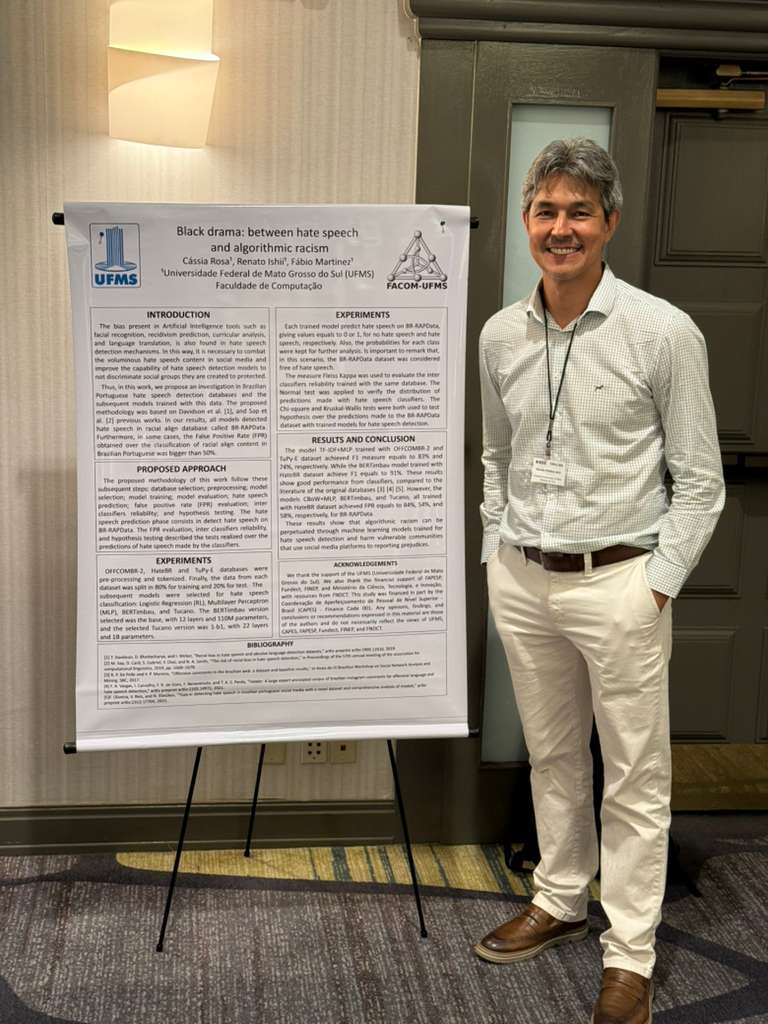

A discussão sobre ética e viés algorítmico em Inteligência Artificial ganhou um capítulo importante recentemente nos Estados Unidos. Renato Porfirio Ishii, professor da Universidade Federal de Mato Grosso do Sul (UFMS), representou a pesquisa científica brasileira no ICMLA 2025 (International Conference on Machine Learning and Applications), um dos eventos mais tradicionais e respeitados da área de aprendizado de máquina no mundo.

Durante a conferência, Renato apresentou o trabalho intitulado “Black drama: between hate speech and algorithmic racism” (“Black drama: entre discurso de ódio e racismo algorítmico”), desenvolvido em parceria com os pesquisadores Cássia Rosa e Fábio Martinez. O estudo lança luz sobre como algoritmos de IA podem perpetuar preconceitos ao analisar a linguagem, confundindo expressões culturais com conteúdo tóxico.

O Rigor da aprovação internacional

Para chegar ao palco do ICMLA, a pesquisa passou por um rigoroso processo de seleção acadêmica. Vale ressaltar que o acesso à grade de apresentações do ICMLA não se dá por adesão comercial ou mera formalização de inscrição.

Trata-se de uma conferência científica onde cada trabalho submetido passa por uma avaliação criteriosa. Um comitê internacional, composto por no mínimo três especialistas da área, analisou a metodologia, a integridade dos dados e a relevância da contribuição científica do artigo sobre viés algorítmico. O trabalho só recebeu o aceite para o debate global após essa aprovação por pares.

Apoio institucional e fomento à pesquisa científica

O desenvolvimento do estudo contou com apoio financeiro e institucional fundamental para sua viabilização, envolvendo diferentes agências e programas de fomento à ciência no Brasil. A pesquisa recebeu suporte da Universidade Federal de Mato Grosso do Sul (UFMS), além de recursos da CAPES, Fundect, FINEP e do Fundo Nacional de Desenvolvimento Científico e Tecnológico (FNDCT). Esses investimentos reforçam o papel estratégico do financiamento público na produção de conhecimento científico de alto impacto e na inserção internacional da pesquisa brasileira em temas críticos como ética, IA e justiça algorítmica.

O Estudo: quando o algoritmo não entende a cultura

A apresentação destacou o chamado “Viés Algorítmico” em modelos de Processamento de Linguagem Natural (PLN). Nesse contexto, plataformas digitais utilizam IAs para moderar conteúdo na internet e bloquear discursos de ódio. Entretanto, a pesquisa investigou se essas ferramentas cometem injustiças ao classificar incorretamente expressões da cultura afro-brasileira.

Para validar essa hipótese, os pesquisadores criaram uma base de dados inédita chamada BR-RAPData. O estudo compilou e analisou letras de músicas de cinco grandes expoentes do Rap e Hip-Hop nacional: Racionais Mc’s, Emicida, Negra Li, Tasha e Tracie e Atitude Feminina.

A escolha do gênero musical foi estratégica para testar a capacidade da IA de compreender o “Pretuguês”, conceito linguístico que abarca o português falado no Brasil com influências africanas e marcas de oralidade.

Resultados alarmantes: A IA e os “falsos positivos”

Os testes revelaram uma falha crítica nas camadas internas de processamento dos modelos atuais. Ao submeter as letras do BR-RAPData a diferentes IAs (incluindo modelos robustos como BERTimbau e Tucano), houve uma alta taxa de “Falsos Positivos”.

Inclusive, em determinados cenários, mais de 50% do conteúdo das letras foi classificado incorretamente como discurso de ódio. Para ilustrar, o estudo demonstrou que trechos da música “Negro Drama”, que narram contextos sociais e de superação, foram interpretados pelos algoritmos como ofensas. Portanto, isso evidencia que, sem o devido ajuste, a tecnologia tende a penalizar narrativas de grupos socialmente vulneráveis.

Expansão da pesquisa e futuro do projeto

A apresentação no ICMLA também delineou os próximos passos desta investigação científica. O objetivo agora é ampliar o escopo do banco de dados BR-RAPData para incluir um número maior de composições de artistas mulheres, permitindo uma análise mais profunda sobre como o viés de gênero se cruza com o viés racial na detecção de discurso de ódio.

Além disso, o projeto prevê a expansão da análise para outros gêneros musicais brasileiros, como o Sertanejo e a MPB. A intenção é construir bases de dados comparativas robustas, seguindo metodologias internacionais, para criar IAs que compreendam melhor a diversidade linguística e cultural do Brasil.